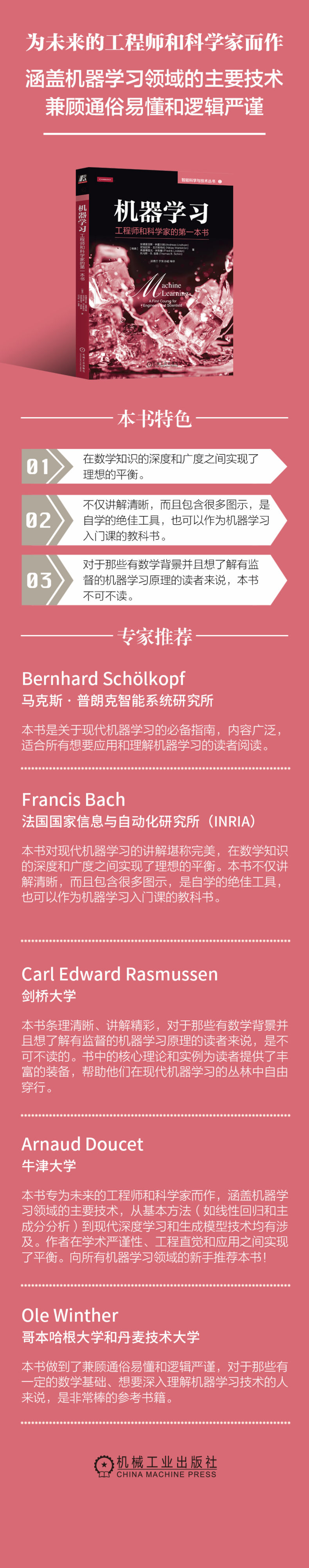

机器学习:工程师和科学家的第一本书

- 字数: 438

- 出版社: 机械工业

- 作者: [瑞典]安德里亚斯·林霍尔姆(Andreas Lindholm),[瑞典]尼克拉斯·瓦尔斯特伦(Niklas Wahlstr?m ),[瑞典]弗雷德里克·林斯滕(Fredrik Lindsten),[瑞典]托马斯·B. 舍恩( Thomas B. Sch?n )

- 商品条码: 9787111753698

- 版次: 1

- 开本: 16开

- 页数: 265

- 出版年份: 2024

- 印次: 1

定价:¥109

销售价:登录后查看价格

¥{{selectedSku?.salePrice}}

库存:

{{selectedSku?.stock}}

库存充足